《欧盟人工智能法》的体系性解读及全景式合规建议

2024-09-03

一���、前言

欧盟《人工智能法》(Regulation (EU) 2024/1689, Artificial Intelligence (“AI”) Act)[1](下称“《欧盟AI法》”“《欧盟人工智能法》”或“EU AI Act”)作为全球最具影响力的也是全球首部综合性人工智能(下文可简称为“AI”)规则���,于2024年5月21日由欧盟理事会(Council of the European Union)批准通过���,并于2024年8月1日后正式生效。该法不同的规则将后续于不同的时间开始发生效力���,具体如下���:

1. 2025年2月2日起���:禁止使用高风险人工智能系统(例如社会评分(social scoring)等利用人类弱点的AI系统)的规定开始生效;

2. 2025年8月2日起���:通用人工智能模型(General-purpose AI models, GPAI)���、治理和责任相关的条款生效;

3. 2026年8月2日起���:大部分条款开始普遍适用。在24个月的过渡期后���,将制定必要的指导方针和标准;以及

4. 2027年8月2日起���:高风险人工智能系统���,特别是那些受其他欧盟立法监管的产品的安全组件���,必须遵守《欧盟人工智能法》。

受《欧盟人工智能法》拘束的全球各相关企业应当依据上述时间表部署落实合规项目[2]。

本文将从《欧盟人工智能法》适用范围入手���,全景梳理展示《欧盟人工智能法》基于风险的合规义务体系���,为k8凯发天生赢家·一触即发律所提供法律服务的中国企业在欧洲经济区(European Economic Area, EEA)[3]使用���、将人工智能投放市场以开展业务提供详尽的合规指引。

二���、对《欧盟人工智能法》适用范围的解读

《欧盟人工智能法》适用于在欧盟范围内将人工智能系统(AI system���,下文可简称为“AI系统”)及嵌入AI系统的通用人工智能模型(General-Purpose AI Models, GPAI Models���,下文可简称为“GPAI模型”)投放市场或投入使用众多利益相关方���,此等利益相关者即受《欧盟人工智能法》的拘束。检视是否须遵守该法规定的合规义务须确定自身在客体���、主体方面是否适格。

(一)适用客体

须使用人工智能系统或使用通用人工智能模型。

《欧盟人工智能法》将“人工智能系统”定义为“旨在以不同程度的自主性运行���,并且在部署后可能表现出适应性���,对于明示或暗示的目标���,从收到的输入中推断出如何生成可能影响物理或虚拟环境的预测���、内容���、建议或决策等输出的基于机器的系统。”基于此���,《欧盟人工智能法》规制的机器系统须满足���:1. 一定程度的自主性;2. 对于虚拟和现实环境表现出适应性;3. 基于明示或暗示的目标完成任务;4. 基于输入的内容完成任务;以及5. 输出预测���、内容���、建议或决策等须可能影响物理或虚拟环境。

未来���,欧盟的行政机构欧洲委员会(European Commission���,下称“委员会”)将依据《欧盟人工智能法》明确构成规制AI系统的具体定义���,k8凯发天生赢家·一触即发律师团队也将持续对此保持关注。

《欧盟人工智能法》将“通用人工智能模型”定义为“除在投放市场之前用于研究���、开发或原型设计活动的人工智能模型外���,具有显著通用性(significant generality)使用大规模自我监督对该人工智能模型进行大量数据训练的人工智能模型。”换言之���,通用人工智能模型关键需要具备显著通用性���,即执行各种不同任务���,并且可以集成到各种下游系统或应用程序中。

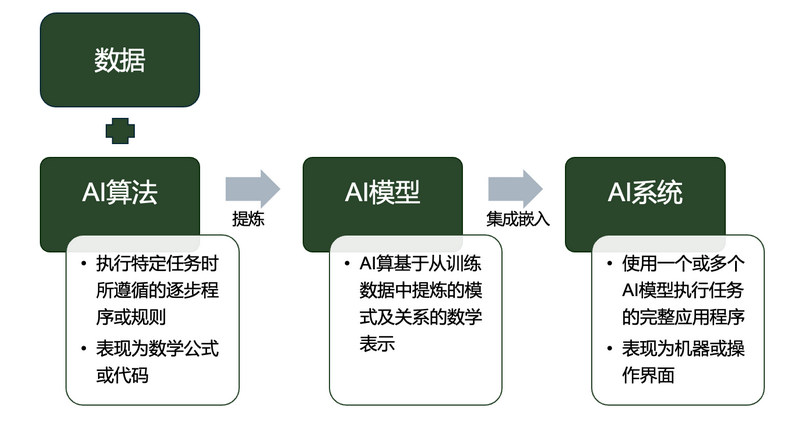

在此���,k8凯发天生赢家·一触即发律师团队基于立法文本及AI技术的理解���,对《欧盟人工智能法》中“AI系统”及“AI模型”从立法及技术的角度可简要的概括为���:AI系统是一套完整的AI应用程序���,它使用一个或多个AI模型执行任务;而嵌入AI系统中的全部AI模型基于AI算法(即AI在执行特定任务时所遵循的一个逐步程序或一组规则)。因此���,AI算法���、模型���、系统之间逐步呈现三层彼此独立而相互依存的AI技术层级。

▲图1为AI算法���、模型���、系统之间的关系图

在《欧盟人工智能法》项下���,只有“AI系统”被定级存在不可接受风险���、高风险���、有限风险时���,或使用的“AI模型”构成“通用AI模型”时���,运营商才须遵守特定的义务(下文第三部分将对此予以详述)。

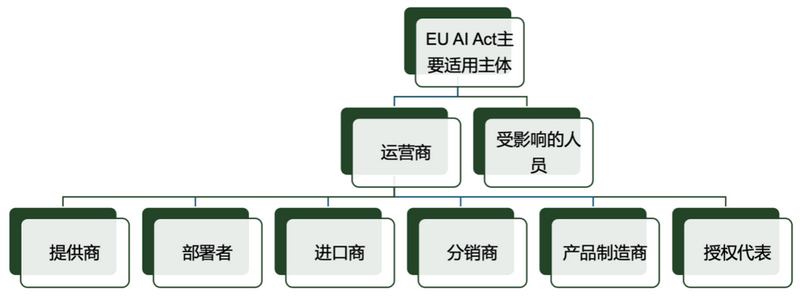

(二)适用主体

包括在欧盟境内将人工智能系统(AI system)投放市场或投入使用的所有人工智能系统的运营商(operator)���,包括提供者���、部署者���、进口商���、分销商���、产品制造商���、欧盟境内未设立的提供商的授权代表(无论其在欧盟境内还是境外);以及受影响的人员���,具体包括���:

▲图2为《欧盟AI法》适用主体范围

1. 提供商(provider)包括���:(1)开发人工智能系统及/或通用人工智能模型���,并将其投放市场的自然人���、法人或其他组织;或者(2)开发人工智能系统及/或通用人工智能模型���,并以自己的名称或商标将人工智能系统投入服务的自然人���、法人或其他组织。

2. 部署者(deployer)是指在个人专业活动过程中或者其他非个人活动中使用人工智能系统的自然人���、法人或其他组织。

3. 进口商(importer)是指在市场上投放带有在第三国设立的自然人或法人名称或商标的人工智能系统的位于或设立在欧盟的自然人或法人。

4. 分销商(distributor)���:在供应链中除提供商或进口商外���,在欧盟市场上提供人工智能系统的自然人或法人。

5. 产品制造商(product manufacturer)���:将人工智能系统与其产品一起以自己的名称或商标投放市场或投入市场的产品制造商。

6. 授权代表(authorised representative)���:已收到并接受人工智能系统或通用人工智能模型提供商的书面授权���,分别代表其履行(perform)和执行(carry out)《欧盟人工智能法》规定的义务和程序的位于或设立在联盟的自然人或法人。通常情况下���,在欧盟境外的主体向欧盟市场投放人工智能系统及模型���,需要书面授权在欧盟设立的授权代表。

其中���,上述主体定义中经常出现的“投放市场(placing on the market)”是指无论是否收取报酬还是免费���,在商业活动过程中提供人工智能系统或通用人工智能模型���,以在欧盟市场上分销或使用;“投入使用”是指直接向部署者提供首次使用的人工智能系统���,或供其在欧盟中自行使用。

三���、《欧盟人工智能法》中“基于风险”的“双合规义务”体系的解读

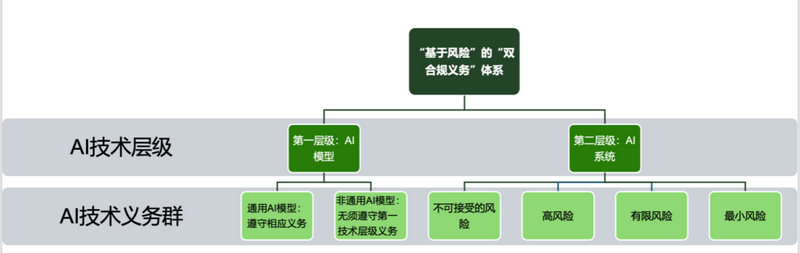

如上论及���,《欧盟人工智能法》不论从主体还是客体检视���,均表现出极广的适用性���,体现了欧盟在人工智能监管领域展现出的雄心勃勃和期待。然而���,《欧盟人工智能法》并非意欲通过监管形成规则垄断���,而是作为欧盟数字战略的一部分���,为开发和利用AI创新技术提供更好的条件���,从而实现科技以人为本���,促进可持续发展和人类福祉[4]。因此���,《欧盟人工智能法》首创“基于风险(risk-based)”的规制技术模式���,即基于AI技术对个人基本权利���、社会造成伤害标准���,相关风险越高���,监管规则就越严格。

基于此���,《欧盟人工智能法》将人工智能系统(实践)分类为���:1. 不可接受风险(unacceptable risk);2. 高风险(high risk);3. 有限风险(limited risk);以及4. 最小风险(minimal risk)。

另一方面���,《欧盟人工智能法》另外针对通用人工智能模型利益相关方创设了另一套合规规则体系���:使用通用人工智能模型的相关主体需要同时履行基于风险的合规义务的同时���,遵守该法项下针对该等通用人工智能模型的合规义务。

从上文AI算法���、模型及系统的关系解读可知���:AI模型和AI系统的义务各自构成两个层级的合规义务群���,运营者应当分别检视���、定级并履行相应的义务。

▲图3为从AI技术层级角度解读的“基于风险”的“双合规义务”体系

第一人工智能技术层级���:AI模型义务群

(一)通用人工智能模型及合规义务

任何使用通用人工智能模型的运营商���,不论其使用的系统或进行的实践是否产生不可接受风险���、高风险���、有限风险���、最小风险���,均仍须遵守通用人工智能模型的合规义务。

1.通用人工智能模型的分类《欧盟人工智能法》将通用人工智能模型分为具有系统性风险的通用人工智能模型以及其他通用人工智能模型。

具备以下任一特征的通用人工智能模型���,即被归类为具有系统性风险的通用人工智能模型���:(1)根据适当的技术工具和方法进行评估���,该模型具有高影响力的能力���,例如可以用来影响医疗保健���、金融或刑事司法等关键领域的决策的GPAI模型;(2)委员会综合考量模型参数���、数据集质量与体量���、计算量���、输入与输出模式���、能力基准���、使用范围���、注册用户数量等因素决定属于具有系统性风险的GPAI模型;或者(3)用于在浮点操作中测量的训练的累积计算量大于1025的GPAI模型;该阈值可由委员会通过授权立法修正。

不属于具有系统性风险的GPAI即是其他通用人工智能模型���,只须履行通用人工智能模型的合规义务���,而无须履行具有系统性风险的通用人工智能模型合规义务。

2.使用通用人工智能模型运营者合规义务

提供商应履行以下主要义务���:(1)起草并及时更新模型的技术文件���,记录培训和测试过程及其评估结果;(2)起草���、更新并向将GPAI模型集成到其AI系统的提供商提供信息和文档���,以使提供商能够很好地了解GPAI模型的能力和局限性;(3)制定政策���,以遵守欧盟关于版权和相关权利的法律法规;以及(4)起草并公开提供关于GPAI模型训练内容的详细摘要。

授权代表应履行以下主要义务���:(1)核实技术文件是否已制备���、GPAI模型提供商已履行其义务;(2)在通用人工智能模型投放市场后10年内���,保留技术文件副本;以及(3)与主管机关合作���,提供必要文件和信息。

3.具有系统性风险的通用人工智能模型运营商合规义务

具有系统性风险的GPAI模型的提供商除履行通用人工智能模型提供商义务外���,还应在评估确定或知道GPAI模型具有系统性风险的两周内���,将相关必要情况立即通知委员会。

(二)非通用人工智能模型及合规义务

不嵌入集成通用人工智能模型的人工智能系统无须遵循其他第一AI技术层级的其他义务。但是如果将此等模型嵌入的AI系统在第二技术层级被归类定级存在不可接受的风险���、高风险���、有限风险���,则应当遵守第二AI技术层级的具体合规义务。

第二人工智能技术层级���:AI系统义务群

(一)禁止——不可接受风险的人工智能实践

不可接受风险的人工智能实践包括如下类型���:

1. 使用潜意识技术���、有目的地操纵或欺骗性技术���,旨在损害个人或特定人群的知情决定能力���,从而使其作出其本不会作出的决定���,从而损害该人���、群体或其他人或其他群体的人工智能实践;

2. 利用自然人或特定群体因年龄���、残疾或特定社会���、经济状况而存在的任何脆弱性���,造成或合理可能造成该人或他人重大伤害���,或严重扭曲该人或该群体的人的行为的人工智能实践;

3. 对自然人或人群进行评估���、分类���、社会评分���,从而导致对某些自然人或群体的有害或不利待遇的人工智能实践;

4. 使用人工智能系统对自然人进行预测自然人实施刑事犯罪风险的评估;

5. 使用人工智能系统���,通过从互联网或闭路电视录像中无目标地抓取(untargeted scraping)面部图像来创建或扩展面部识别数据库;

6. 在工作场所和教育机构使用人工智能系统推断自然人的情绪���,但出于医疗或安全原因打算将人工智能系统投入使用或投放市场的情况除外;

7. 使用生物识别分类系统���,根据生物识别数据对自然人进行单独分类���,以推断或推断其种族���、政治观点���、工会成员身份���、宗教或哲学信仰���、性生活或性取向;以及

8. 除非对于有针对性地搜寻特定的绑架���、贩卖人口或性剥削受害者���,以及搜寻失踪人员���,或为防止人身伤害���、恐怖袭击等紧急避险情况所绝对必要���,为执法目的在可进入的公共场所使用“实时”远程生物识别系统。

(二)合规义务要求——“高风险”人工智能系统

1.高风险人工智能系统的范围

高风险人工智能系统包括以下类型���:

(1)人工智能系统旨在用作产品的安全组件���,或者人工智能系统本身就是产品的;

(2)生物识别技术���:包括远程生物识别系统���、根据敏感或受保护的属性或特征进行生物识别分类的人工智能系统���、用于情感识别的人工智能系统;

(3)关键基础设施���:人工智能系统旨在作为关键数字基础设施���、道路交通或供水���、天然气���、供暖或电力的管理和运营中的安全组件;

(4)教育和职业培训���:用于确定准入或录取���、将自然人分配到各级教育和职业培训机构���、评估学习成果���、评估个人在各级教育和职业培训机构内或将能够接受或能够获得的适当教育水平���、监测和检测学生在各级教育和职业培训机构或内部的考试期间的违禁行为的系统;

(5)就业���、工人管理和自营职业���:用于招聘或选择自然人���、评估候选人���、监测和评估此类关系中人员的绩效和行为���、促进或终止与工作相关的合同关系���、根据个人行为或个人特征或特征分配任务的系统;

(6)基本私人服务以及基本公共服务和福利���:评估自然人获得基本公共援助福利和服务的资格���、评估自然人的信誉或确定其信用评分(用于检测金融欺诈的除外)���、用于与人寿和健康保险有关的自然人的风险评估和定价���、评估和分类自然人的紧急呼叫���,或用于派遣或确定派遣紧急第一反应服务的优先级的系统;

(7)执法���:支持执法当局或代表他们来评估自然人成为刑事犯罪受害者的风险���、用作测谎仪或类似工具���、评估自然人犯罪或再犯罪的风险���、支持执法当局在调查或起诉刑事犯罪过程中评估证据的可靠性等系统;

(8)移民���、庇护和边境管制管理���:作为测谎仪或类似工具���、评估打算进入或已经进入成员国领土的自然人构成的风险���、协助主管公共当局审查庇护���、签证或居留许可申请���、处理申请身份的自然人资格的相关投诉等系统;以及

(9)司法和民主程序���:协助司法当局���、替代性争议解决方式机构研究和解释事实和法律���、影响选举或公投的结果���,或自然人在选举或公投中行使投票权时的投票行为的系统。

此外���,欧洲委员会添加或修改上述高风险人工智能系统的清单类目。

2.合规义务主体之一——提供商

高风险人工智能系统的运营商必须严格履行相关义务和责任���,以确保这些系统的安全性���、透明度和可问责性。

针对提供商的主要合规义务包括���:

(1)建立风险管理体系���:高风险人工智能系统的提供者必须实施风险管理系统���,以在人工智能系统的整个生命周期内识别���、评估和降低潜在风险;

(2)数据治理和管理���:高风险人工智能系统开发和运行过程中所用数据的质量���、完整性和准确性;

(3)制备技术文档���:在人工智能系统投放市场或投入使用之前���,应当起草和维护全面性的技术文档���,记载有关人工智能系统的设计���、开发和预期用途的详细信息;

(4)记录和保存记录���:高风险人工智能系统具有记录功能���,以记录和保存操作数据���,以保证系统的可追溯性和问责制;针对提供商���,应在高风险人工智能系统投放市场或投入使用后10年内保存技术文档���、质量管理体系文档���、欧盟符合性声明等记录;

(5)透明度和向部署者提供信息���:高风险人工智能系统的设计和开发应确保其操作足够透明���,使部署者能够解释系统的输出并适当使用;

(6)人类监督���:高风险人工智能系统的设计方式应允许人类进行有效干预���,防止或减轻相关风险;

(7)准确性���、稳健性���、网络安全���:高风险人工智能系统的设计和开发方式应达到适当的准确性���、稳健性和网络安全水平;

(8)必要信息义务���:在高风险人工智能系统���、包装上或其随附文件上注明其名称���、注册商号或注册商标���,以及可以联系他们的地址;

(9)质量管理体系���:提供商应建立质量管理体系���,以书面政策���、程序和指示的形式记录监管合规战略���、数据管理系统和程序���、风险管理系统等;

(10)自动生成的日志保存义务���:除非另有规定���,提供商应保存其控制范围内自动生成的日志至少6个月;

(11)一致性评估(conformity assessment)义务���:提供商应当对高风险人工智能系统进行一致性评估���,以证明其符合该法的规定;

(12)欧盟符合性声明义务���:提供商应为高风险人工智能系统起草一份机器可读���、实物或电子签名的欧盟符合性声明���,并在系统投放市场或投入使用后10年内由国家主管当局处置;

(13)CE标识义务���:提供商应当在高风险人工智能系统上明显���、清晰且不可磨灭地贴上符合《欧洲议会和欧盟理事会第765/2008号条例》[5]第30条的CE标识;

(14)欧盟数据库注册义务���:在高风险人工智能系统投放市场或投入使用之前���,在该法第71条所述的欧盟数据库中注册提供商及其系统。该义务同样适用于授权代表;

(15)纠正及信息义务���:提供商认为或有理由认为他们投放市场或投入使用的高风险人工智能系统不符合本条例���,应立即采取必要的纠正措施���,并将相关高风险人工智能系统通知分销商���,并在适用的情况下通知部署者���、授权代表和进口商;

(16)符合欧盟指令和条例规定的无障碍要求;

(17)通知主管机关与主管机关合作义务;以及

(18)与部署者合作���,在人工智能监管沙盒(AI regulatory sandboxes)[6]以外的现实世界条件下对高风险人工智能系统的测试。

3.合规义务主体之二——部署者

针对部署者的主要合规义务包括���:

(1)人类监督义务���:部署者应指派具备必要能力���、培训和权力以及必要支持的自然人进行人类监督;

(2)依据系统随附的使用说明使用人工智能系统的义务;

(3)监控系统���、通知及作出紧急措施义务���:部署者应监控高风险人工智能系统的运行情况���,并酌情通知提供商。如出现对个人的健康或安全或基本权利构成风险及相关严重事件���,应毫不拖延地通知提供商或分销商以及相关市场监督机关���,并应暂停使用该系统;

(4)自动生成的日志保存义务���:除非另有规定���,部署者应保存其控制范围内自动生成的日志至少6个月;

(5)雇主通知工会���、工人义务���:在工作场所投入使用或使用高风险人工智能系统之前���,作为雇主的部署者应通知工人代表和受影响的工人;

(6)与相关主管机关合作的义务;以及

(7)基本权利影响评估义务���:高风险人工智能系统的部署者应对使用此类系统可能产生的基本权利产生的影响进行评估���,主要包括描述部署者的流程���、高风险人工智能系统使用的时间段和频率���、在特定情况下可能受到其使用影响的自然人和群体的类别���、针对特定人或人群产生具体伤害风险���、人类监督措施等。

4.合规义务主体之三——进口商

针对进口商的主要合规义务包括���:

(1)验证一致性评估结果���、制备技术文档���、CE标识���、任命授权代表的义务���,如发现为伪造或虚假���,应当通知监管机关;

(2)在其高风险人工智能系统及其包装或随附文件(如适用)上注明其名称���、注册商号或注册商标���,以及可以联系他们的地址;

(3)保留证书���、声明的义务���:进口商应在高风险人工智能系统投放市场或投入使用后10年内保留颁发的证书���、使用说明���、欧盟合格声明的副本;以及

(4)与主管机关合作���,提供必要文件和信息。

5.合规义务主体之四——分销商

针对分销商的主要合规义务包括���:

(1)验证义务���:验证系统是否带有所需的CE标志���、颁发的证书���、欧盟符合性声明和使用说明的副本���,验证系统的提供商和进口商遵守了各自的义务;

(2)在不符规定���、发生风险时���,及时采取必要措施���,停止���、召回提供系统���、通知提供商���、进口商���、主管机关;以及

(3)与主管机关合作���,提供必要文件和信息。

6.合规义务主体之五——授权代表

针对授权代表的主要合规义务包括���:

(1)核实欧盟符合性声明���、技术文件���、一致性评估报告是否存在;

(2)在高风险人工智能系统投放市场或投入使用后10年内���,向主管机关提供指定授权代表的提供商的详细联系信息���、欧盟合格声明副本���、技术文件以及颁发的证书;

(3)与主管机关合作���,提供必要文件和信息;以及

(4)履行欧盟数据库注册义务(如适用)或确保所登记的信息正确无误。

(三)合规义务——“有限风险”人工智能系统

1.有限风险人工智能系统的范围

有限风险人工智能系统包括如下类型���:

(1)旨在与自然人直接互动的人工智能系统;

(2)生成合成音频���、图像���、视频或文本内容的通用人工智能系统;

(3)情感识别系统或生物识别分类系统;以及

(4)生成或操纵构成深度伪造的图像���、音频或视频内容的人工智能系统。

2.有限风险合规义务

特定的有限风险人工智能系统的运营商应当履行特定的透明度义务���,具体如下主要义务���:

(1)针对旨在与自然人直接互动的人工智能系统���,提供商应确保其设计和开发方式可使得有关自然人被告知他们正在与人工智能系统交互;

(2)针对生成合成音频���、图像���、视频或文本内容的通用人工智能系统���,提供商应确保人工智能系统的输出以机器可读格式标记���,并可检测为人工生成或操作;

(3)针对情感识别系统或生物识别分类系统���,部署者应将该系统的运行情况通知接触到该系统的自然人���,并按照《通用数据保护条例》(General Data Protection Regulation, GDPR)的规定处理数据;以及

(4)针对生成或操纵构成深度伪造的图像���、音频或视频内容的人工智能系统���,部署者应披露该内容是人为生成或操纵的。

(四)无合规义务——仅限最小风险人工智能系统

不属于不可接受风险���、高风险���、有限风险的人工智能系统���,如果也并未嵌入或者基于通用人工智能模型���,则无须承担《欧盟人工智能法》规定的监管义务。

四���、违反合规义务的法律责任与后果

根据《欧盟人工智能法》���,出现违规的法律责任主要分为行政处罚和民事赔偿两大类别���,暂未出现刑事责任处罚。

其中���,民事赔偿系欧盟数字技术责任体系改革的重要一环���,2022年由委员会提议���,目前正由欧洲议会及欧盟理事会两个立法机关审读和讨论���,将通过修订《产品质量责任指令》(Product Liability Directive)���,并制定《人工智能责任指令》(Artificial Intelligence Liability Directive)���,以全方位地为使用数字技术而受损的相关主体提供充分的民事救济体系。我们将用下一篇文章对此进行全面的介绍和阐释。

其次���,行政处罚方面���,行政处罚主要有如下从高到低三档���:

(1)违反《欧盟人工智能法》使用禁止使用的具有不可接受风险的AI系统的运营商���,最高可处以3500万欧元的罚款或最高为上一财政年度全球年营业额总额的7%(以较高者为准);

(2)违反《欧盟人工智能法》大部分要求的除向主管机关提供信息以外的其他合规和监管义务的运营商���,最高1500万欧元或上一财政年度全球年营业额3%的罚款(以较高者为准);以及

(3)违反《欧盟人工智能法》通知主管机构的或向主管当局提供虚假���、不完整或误导性信息���,最高750万欧元或上一财政年度全球年营业额1%的罚款(以较高者为准)。

对于包括初创企业在内的中小型企业(small and medium-sized enterprises, SME)���,适用较低的处罚金额。

同时���,欧盟成员国主管机关还应考虑侵权的性质���、严重性和持续时间及其后果���、实施侵权的运营商的规模���、年营业额和市场份额���、与国家主管当局的合作程度���、运营商实施的技术和组织措施等因素以作出处罚决定。

五���、结语���:中国企业之应对措施

考虑到《欧盟人工智能法》规定的处罚金额巨大���、相关合规义务体系错综复杂���、且合规及监管模式体现出高度技术专业性���,k8凯发天生赢家·一触即发律师建议���:

(一)中国出海欧洲经济区的企业应对在该法相关义务条款的宽限期内做好充足的准备���,全面并实时关注了解《欧盟人工智能法》及配套规则的规定及实践。

(二)依据《欧盟人工智能法》并结合企业使用的AI系统及模型的特性���,提前对自身使用的AI系统及模型进行系统性定级及评估���,厘定利益相关方合规监管义务及责任。

(三)在涵盖AI模型和系统的规划���、设计���、研发���、部署的全人工智能开发生命周期(AI development lifecycle)的各个阶段���,从法律合规���、技术合规和运营合规等不同维度���,综合体系性地建立健全有效的合规和风险控制制度���,以保障利益相关方履行相应义务���,从而有效预防风险。

参考文献���:

[1]全称为《2024年6月13日欧洲议会和欧盟委员会第(EU)2024/1689 号关于人工智能的统一规则条例���,该条例修订了第(EC)300/2008号���、第(EU)167/2013号���、第(EU)168/2013号���、第(EU)2018/858号���、第(EU)2018/1139号和第(EU)2019/2144号条例以及第2014/90/EU号���、第(EU)2016/797号和第(EU)2020/1828号指令(“人工智能法”)》(Regulation (EU) 2024/1689 of the European Parliament and of the Council of 13 June 2024 laying down harmonised rules on artificial intelligence and amending Regulations (EC) No 300/2008, (EU) No 167/2013, (EU) No 168/2013, (EU) 2018/858, (EU) 2018/1139 and (EU) 2019/2144 and Directives 2014/90/EU, (EU) 2016/797 and (EU) 2020/1828 (Artificial Intelligence Act))。

[2]实际上���,即使《欧盟人工智能法》规定有行政罚款以及其他行政处罚责任���,欧盟目前正在酝酿的数字技术责任体系改革���,将特别地为人工智能系统和模型规定创制民事责任���,从而使得《欧盟人工智能法》获得全面的可执行性。下一篇文章我们将专门对此予以详尽阐释。

[3]依据《欧盟人工智能法》标题项下“与欧洲经济区相关的文本(Text with EEA relevance)”���,结合《欧洲经济区协定》(Agreement on the European Economic Area)的规定���,《欧盟人工智能法》不仅适用于欧盟成员国���,也同样适用于欧洲经济区国家。欧盟经济区包括27个欧盟成员国以及冰岛���、列支敦士登和挪威。

[4]参考《经合组织人工智能原则》(OECD AI Principles)及《欧盟人工智能法》第1条第(1)款。

[5]即《2008年7月9日欧洲议会和欧盟理事会与产品销售有关的认证和市场监督要求第765/2008号条例》(Regulation (EC) No 765/2008 of the European Parliament and of the council of 9 July 2008 setting out the requirements for accreditation and market surveillance relating to the marketing of products and repealing Regulation (EEC) No 339/93)���,2010年1月1日生效。

[6]人工智能监管沙盒是指由监管机构建立的受控环境���,同时使用监督测试(supervised testing)环境���,以使公司和组织可以在监管机构的监督下测试���、开发和测试人工智能技术。该项技术旨在促进创新���,同时确保人工智能系统符合现有法规���,并满足安全和道德标准。

本文作者���:

指导合伙人���:

声明���:

本文由k8凯发天生赢家·一触即发律师事务所律师原创���,仅代表作者本人观点���,不得视为k8凯发天生赢家·一触即发律师事务所或其律师出具的正式法律意见或建议。如需转载或引用本文的任何内容���,请注明出处。